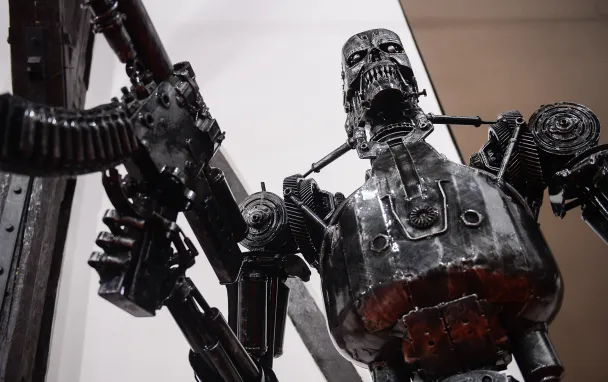

Кошмар прогресса: окажутся ли роботы-убийцы под запретом

Пока премьер Дмитрий Медведев и Аркадий Волож катались на беспилотном «Яндекс.Такси» по «Сколково», военные инженеры придумывали, как адаптировать технологии беспилотного транспорта для создания нового оружия.

На самом деле, технологии — не совсем то, чем они кажутся. Проблема всей технологической эволюции в том, что грань между коммерческими роботами «для жизни» и военными роботами-убийцами невероятно тонкая, и перейти ее ничего не стоит. Пока что они выбирают маршрут движения, а завтра смогут сами выбирать, какую цель уничтожить.

Это не первый раз в истории, когда технологический прогресс ставит под вопрос само существование человечества: сначала ученые создали химическое, биологическое и ядерное оружие, теперь — «автономное оружие», то есть роботов. Разница лишь в том, что до сего дня бесчеловечным считалось оружие «массового поражения» — то есть не выбирающее, кого ему убивать. Сегодня перспектива изменилась: куда более безнравственным кажется оружие, которое будет убивать с особой разборчивостью, выбирая жертв на собственный вкус. И если какую-нибудь воинственную державу останавливало то, что, примени она биологическое оружие, пострадают все вокруг, то с роботами все сложнее — их можно запрограммировать на уничтожение конкретной группы объектов.

В 1942 году, когда американский писатель Айзек Азимов сформулировал три закона робототехники, все это казалось захватывающим, но совершенно нереалистичным. Эти законы гласили, что робот не может и не должен причинять вред или убивать человека. А еще они должны беспрекословно подчиняться воле человека, кроме тех случаев, когда его приказы будут противоречить вышеизложенному императиву. Теперь, когда автономное оружие стало реальностью и вполне может попасть в руки террористов, оказалось, что программисты как-то забыли заложить в его ПО законы Азимова. А значит, роботы могут представлять опасность, и никакие гуманные законы или принципы не смогут их остановить.

Разработанная Пентагоном ракета сама обнаруживает цели благодаря программному обеспечению, искусственный интеллект (ИИ) идентифицирует мишени для британских военных, а Россия демонстрирует беспилотные танки. На разработку роботизированной и автономной военной техники в различных странах тратятся колоссальные средства, хотя увидеть ее в действии мало кому хочется. Как большинство химиков и биологов не заинтересованы в том, чтобы их открытия в итоге были использованы для создания химического или биологического оружия, так и большинство исследователей ИИ не заинтересованы в создании оружия на его основе, потому что тогда серьезный общественный резонанс повредит их исследовательским программам.

В своем выступлении в начале Генеральной Ассамблеи Организации Объединенных Наций в Нью-Йорке 25 сентября Генеральный секретарь Антониу Гутерреш назвал технологию ИИ «глобальным риском» наряду с изменением климата и растущим неравенством доходов: «Давайте называть вещи своими именами, — сказал он. — Перспектива, что машины будут определять, кому жить — отвратительна». Вероятно, Гутерреш — единственный, кто может призвать военные ведомства одуматься: ранее он разбирался с конфликтами в Ливии, Йемене и Сирии и занимал должность Верховного комиссара по делам беженцев.

Проблема в том, что при дальнейшем развитии технологий роботы сами смогут решать, кого убивать. И если у одних стран такие технологии будут, а у других нет, то бескомпромиссные андроиды и дроны предрешат исход потенциальной битвы. Все это противоречит всем законам Азимова одновременно. Алармисты могут всерьез тревожиться о том, что самообучаемая нейросеть выйдет из-под контроля и перебьет не только врага, но и всех людей вообще. Однако перспектива даже вполне послушных машин-убийц совсем не радужна.

Наиболее активная работа в области искусственного интеллекта и машинного обучения на сегодняшний день ведется не в военной, а в гражданской сфере — в университетах и компаниях вроде Google и Facebook. Но большая часть этих технологий может быть адаптирована к военному использованию. Это значит, что потенциальный запрет на исследования в этой области, коснется и гражданских разработок.

В начале октября неправительственная американская организация «Кампания «Остановить роботов-убийц» отправила письмо в Организацию Объединенных Наций с требованием ограничить разработку автономного оружия на международном законодательном уровне. ООН дала понять, что поддерживает эту инициативу, а в августе 2017 года к ней присоединились Илон Маск и участники Международной конференции ООН по вопросам использования искусственного интеллекта (IJCAI). Но фактически США и Россия выступают против таких ограничений.

Последняя встреча 70 стран-участниц Конвенции о конкретных видах обычного оружия (о «негуманном» оружии) состоялась в Женеве в августе. Дипломаты не смогли достичь консенсуса относительно того, как глобальная политика в отношении ИИ может быть реализована. Некоторые страны (Аргентина, Австрия, Бразилия, Чили, Китай, Египет и Мексика) высказались в поддержку законодательного запрета разработок роботизированного оружия, Франция и Германия предложили ввести добровольную систему таких ограничений, однако Россия, США, Южная Корея и Израиль заявили, что не собираются ограничивать исследования и разработки, которые ведутся в этой области. В сентябре Федерика Могерини, высокопоставленный представитель Европейского союза по вопросам внешней политики и политики безопасности, заявила, что оружие «влияет на нашу коллективную безопасность», поэтому решение вопроса жизни и смерти должно в любом случае оставаться в руках человека.

Холодная война-2018

Должностные лица американских обороны считают, что автономное оружие необходимо Соединенным Штатам, чтобы сохранить свое военное преимущество перед Китаем и Россией, которые также вкладывают деньги в аналогичные исследования. В феврале 2018 года Дональд Трамп потребовал выделить $686 млрд на оборону страны в следующем финансовом году. Эти расходы всегда были довольно высокими и снижались разве что при предыдущем президенте Бараке Обаме. Однако Трамп — неоригинально — аргументировал необходимость их увеличения технологической конкуренцией с Россией и Китаем. В 2016 году в бюджете Пентагона было заложено $18 млрд на разработку автономного оружия в течение трех лет. Это немного, но тут нужно учесть один очень важный фактор.

Большинство разработок в области ИИ в США ведутся коммерческими компаниями, поэтому они оказываются в широком доступе и могут быть проданы в коммерческих целях другим странам. У Пентагона нет монополии на передовые технологии машинного обучения. Американская оборонная промышленность больше не ведет собственные исследования так, как это делалось во время «холодной войны», а использует наработки стартапов из Кремниевой долины, а также Европы и Азии. В то же время в России и Китае такие исследования находятся под строгим контролем оборонных ведомств, что, с одной стороны, ограничивает приток новых идей и развитие технологий, но, с другой, гарантирует госфинансирование и защиту.

По оценке экспертов The New York Times, военные расходы на автономные военные машины и беспилотные летательные аппараты превысят $120 млрд в течение следующего десятилетия. Это означает, что дискуссия в конечном счете сводится не к тому, стоит ли создавать автономное оружие, а к тому, какую степень независимости ему дать.

Сегодня полностью автономного оружия не существует, но заместитель председателя Объединенного комитета начальников штабов генерал Пол Дж. Сельва из ВВС еще в 2016 году заявил, что через 10 лет Соединенные Штаты получат технологию создания такого оружия, которое сможет самостоятельно решить, кого и когда убивать. И пока страны спорят о том, стоит ли ограничивать ИИ или нет, может стать слишком поздно.