«Власти смогут «хакнуть» людей»: глава Huawei и автор Sapiens поспорили об опасности искусственного интеллекта

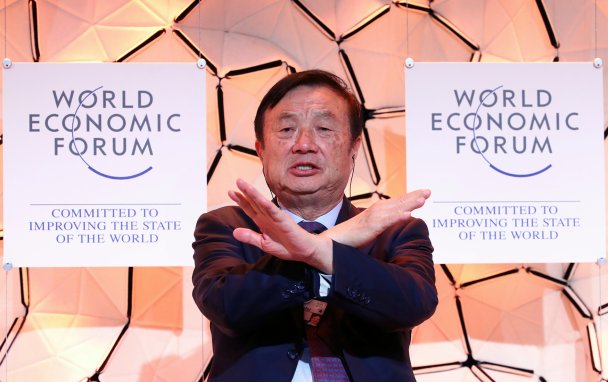

Основатель и генеральный директор Huawei Жэнь Чжэнфэй, занимающий 276-е место в списке китайских миллиардеров по версии Forbes, и автор бестселлера «Sapiens. Краткая история человечества» Юваль Ной Харари поспорили о технологической гонке вооружений на форуме в Давосе. Forbes пересказывает основные тезисы этого диалога.

Юваль Харари:

Технологическая гонка вооружений может привести к появлению «информационных колоний». Может повториться ситуация, которая сложилась в XIX веке: лидеры индустрии снова будут управлять миром экономически и политически. Современная гонка вооружений — это империалистическая гонка вооружений. Если у тебя есть все данные о стране, не нужно отправлять туда солдат. Власти смогут «хакнуть» людей, имея достаточно развитые биотехнологии. Много говорят о взломе компьютеров, телефонов или банковских счетов, но реальный вопрос — это взлом человека. Если у вас достаточно данных обо мне, достаточно биологических навыков и есть сильная технология, вы сможете взломать мое тело, мой мозг, мою жизнь… Вы можете достигнуть этапа, когда будете знать меня лучше, чем я сам. Мы близки к точке невозврата. И мы не имеем понятия, что произойдет после.

Шутки кончились: какую работу оставит человеку искусственный интеллект

Жэнь Чжэнфэй:

Технологии создаются для хорошего. Их развитие служит благим целям, а не плохим. Развитие технологий происходит синхронно с нашей биологической эволюцией. Общество эволюционировало и пришло к тому, что мы имеем сегодня, — информационному обществу. Быстрое развитие технологий пугает людей, и они думают, хорошо это или плохо. Лично я думаю, что хорошо. Технологии создаются для того, чтобы улучшать, а не для того, чтобы разрушать. Когда я только родился, в Японии взорвалась атомная бомба. Когда мне было 6-7 лет, люди боялись атомной войны. Но не стоит забывать о пользе атомной энергии и применении радиации в медицине. Сегодня мы также боимся искусственного интеллекта. Он не так опасен, как атомная бомба. То, что он может сделать для общего блага, это важно.

Юваль Харари:

Опасность искусственного интеллекта не так очевидна, как опасность атомной бомбы. Люди понимают, что если начнется атомная война, выиграть ее будет невозможно. Однако они думают, что можно выиграть гонку технологических вооружений (искусственного интеллекта). Нельзя. Власти США еще не понимают последствий использования искусственного интеллекта.

Глава Alphabet предупредил об угрозах искусственного интеллекта

Жэнь Чжэнфэй:

Если власти США еще не понимают последствий использования искусственного интеллекта, то китайские власти еще даже не начали об этом думать. Если бы они думали, они бы больше финансировали образование и разработки, исследования. Китай не может развивать искусственный интеллект, потому что эти разработки требуют слишком многого (исследования, ресурсы и т. д.). Весь мир занимается изучением искусственного интеллекта. Однако вряд ли через 20-30 лет будет возможно «хакнуть» человеческое тело. Скорее искусственный интеллект будет использоваться в производстве.

Юваль Харари:

Многие технологии опасны, и мы это понимаем. Логика гонки вооружений в том, что Америка это делает, Китай тоже это делает, значит и мы не можем оставаться в стороне. Самое важное, если у правительства будет достаточно информации обо мне, они смогут предсказывать мои решения лучше меня самого. Если кто-то знает о кандидате на пост президента в Бразилии или о новом судье Верховного суда США всю информацию, включая то, что они делали в 20 лет в колледже, — это все еще свободная страна или «информационная колония»?

Искусственный интеллект оказался неразрешимой задачей

Жэнь Чжэнфэй:

Когда какой-либо ученый узнает правду, он делится ею с миром. Весь мир связан. Множество разнообразных технологий связано. Когда-то изобрели машину, и теперь существует множество разных моделей, которые конкурируют между собой на рынке.

Юваль Харари:

Правительство создает инструменты для наблюдения. Если им так нравится наблюдение, горожане могут настроить инструменты так, чтобы наблюдать за ними. Инженер может создать инструмент на базе искусственного интеллекта, чтобы наблюдать за коррупцией. Если есть антивирус для компьютера, то будет и «антивирус» для сознания, который защитит, если кто-то захочет вас «хакнуть» и манипулировать вами.

Новая сексуальность: почему теперь даже в калькуляторах находят искусственный интеллект