Совесть для робота: как действуют алгоритмы добра и зла

Стремительное развитие технологий ставит человечество лицом к лицу с вопросами, которые еще недавно казались совершенно абстрактными. Вот, например, «проблема вагонетки». Тяжелая вагонетка мчится по рельсам прямо к той точке, где на ее пути лежат пять человек (возможно, детей) — связанные и совершенно беспомощные перед неотвратимой угрозой. Вы можете перевести стрелку и пустить вагонетку по другому пути. Но там к рельсам тоже привязан человек — правда, всего один. Должны ли вы перевести стрелку? С одной стороны, пять невинных жизней явно больше, чем одна. С другой — кто вы такой, чтобы решать судьбу человека, которому, если бы не вы, вообще ничто бы не угрожало?

Ситуация щекотливая, но, к счастью, достаточно искусственная: не так уж часто нам поручают переводить железнодорожные стрелки, да еще и со столь серьезными последствиями. Когда в 1967 английский философ Филиппа Фут формулировала свой «парадокс вагонетки», никто не подозревал, что спустя всего полвека подобные вопросы придется решать не философам и богословам, а программистам.

Дело в том, что очень похожая задача возникает при проектировании автомобилей-беспилотников. На дороге возникла критическая ситуация, под угрозой жизни нескольких пешеходов, и спасти их можно только одним способом: направив беспилотный автомобиль в столб. При этом, скорее всего, пострадает пассажир. И снова пять пешеходов — это больше, чем один пассажир, и снова вопрос: кто дал бездушной машине право решать судьбы людей? Может, пассажир и сам бы мог рискнуть жизнью ради спасения ближнего, но своему беспилотнику он такой выбор доверить не готов. Он и так уже доверил ему собственную жизнь, и не для того, чтобы машина распоряжалась ею по своему усмотрению.

Пару лет назад официальный представитель Mercedes Benz Кристоф фон Хуго заявил, что беспилотные автомобили компании будут спасать жизнь пассажира любой ценой, раз уж тот доверил свою безопасность транспортному средству прославленной марки. Вскоре компания официально дезавуировала это мнение — имидж хладнокровного убийцы пешеходов явно не пошел бы ей на пользу. Тем временем в российской компании Cognitive Technologies в результате опроса фокус-групп пришли к выводу, что искусственный интеллект должен просто минимизировать ущерб, не ставя пассажира беспилотника в привилегированное положение. Однако после наводящих вопросов в личных собеседованиях члены фокус-групп очень легко меняли свое мнение на противоположное. Между прочим, в 2014 году испанский психолог Альберт Коста обнаружил, что нравственный выбор человека в «дилемме вагонетки» зависит даже от того, на каком языке ставить задачу: если обсуждать эту тему на неродном для испытуемых языке, люди гораздо чаще выбирают «рациональное» решение, т. е. минимизацию вреда. В переводе на родной язык все сразу же становится сложнее.

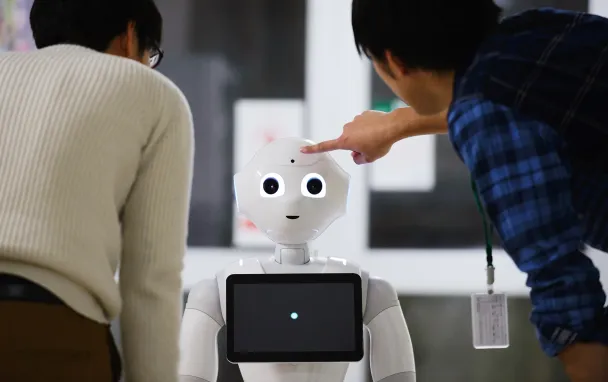

О важности этой проблемы можно судить хотя бы по тому, что в своем недавнем докладе Римский клуб назвал неэтичное использование искусственного интеллекта одним из главных вызовов, стоящих перед человечеством. И дело тут явно не в ИИ, а в людях: прежде чем программировать совесть для робота, им следовали бы сначала самим разобраться, почему они считают одни поступки хорошими, а другие дурными. Этой проблеме было посвящено недавнее исследование психологов из университета Северной Каролины. В 2014 году они разработали теоретическую модель, которую назвали «Агент — действие — последствие» (ADC model). Оставалось лишь экспериментально убедиться, что люди действительно следуют принципам этой модели, сталкиваясь с ситуациями нравственного выбора. Это и сделано в их недавней научной работе.

Согласно модели, люди, оценивая тот или иной поступок, принимают во внимание три фактора. Во-первых, личность того, кто принимает решение и, в частности, его мотивы. Во-вторых, само деяние (например, правда выглядит в наших глазах лучше лжи, даже если мы ничего не знаем ни о мотивах, ни о последствиях правдивости). В-третьих, в расчет берутся последствия деяния. Так, к примеру, поступок семьи, усыновившей ребенка ради того, чтобы получить правительственное пособие, может быть признан хорошим, так как хороши само деяние и его последствия, хотя и не мотивы. Хорошим может быть признан и поступок человека, подарившего свое пальто бездомному, который немедленно продал подарок, купил наркотики и умер от передозировки. Здесь хороши мотив и деяние, хотя и не последствия.

Все люди, независимо от знаний и убеждений, в целом согласны между собой по вопросу «Что такое хорошо и что такое плохо?»

Исследователи предлагали свои выдуманные сценарии добрых и злых поступков двум группам экспертов: профессиональным философам и этикам (141 человек) и выборке из 528 испытуемых, не имевших специальной подготовки.

Оказалось, что оценка поступка сильно зависит от последствий. Там, где речь не шла о жизни и смерти, испытуемые принимали во внимание главным образом сам поступок и его мотивы. Однако, когда ставки были высоки, последствия выходили на первый план. При спасении самолета, полного пассажиров, оценки поступков зависели уже исключительно от того, сколько жизней удалось спасти. Более того, в случае благополучного исхода люди придавали меньше значения разнице между добрыми и дурными мотивами и поступками, чем когда ситуация разрешалась не идеальным образом.

Любопытно, что оценки были практически одинаковы как в группе профессионалов-гуманитариев, так и среди неподготовленной публики. По мнению авторов статьи, это свидетельствует о том, что сама структура морального суждения не зависит от того, насколько глубоко вы изучали этику (и, в частности, слышали ли вы что-нибудь о Филиппе Фут и ее этических парадоксах). Другими словами, все люди, независимо от знаний и убеждений, в целом согласны между собой по фундаментальному вопросу «Что такое хорошо и что такое плохо?»

Доктор Велько Дублевич, автор исследования, считает, что его ADC-модель поможет в тех ситуациях, когда возникает потребность алгоритмизировать механизм нравственного выбора — например, в тех же беспилотных автомобилях. Эти принципы можно будет положить в основу когнитивной архитектуры, применяемой в самых различных технологических решениях с использованием ИИ.