Лучше, чем люди: могут ли цифровые «двойники» стать проблемой для общества

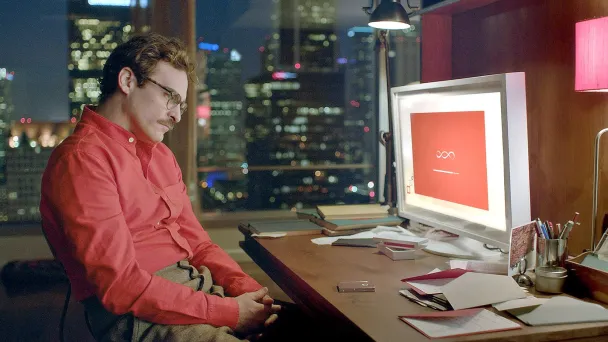

В 2016 году бывшая российская журналистка Евгения Куйда запустила проект Luka, который позволил ей продолжить виртуальное общение с трагически погибшим другом. Тогда это был чат-бот, который, используя переписки в соцсетях, позволял общаться с умершими. Новость обескураживала — в то время мировые СМИ и пользователи соцсетей как раз начали рассуждать на тему этики цифрового наследия. Со временем стартап журналистки вырос в приложение Replika, позволяющее общаться с виртуальным другом, с которым можно не чувствовать себя одиноким. Сейчас же сервисы типа Doppl обещают сделать цифрового клона из кого угодно. Причем в различных форматах — фото, аудио, видео, текст. С помощью Doppl можно, например, поддерживать связь с цифровыми копиями известных людей. А подобные HeyGen labs сервисы помогают уже самим авторам контента звучать для своих подписчиков на разных языках мира. Это позволяет лидерам мнений уже сегодня расширять свое влияние, стирая границы.

Аватары на конвейере

Для тех, кто сегодня строит свой персональный бренд есть и другие сервисы, которые позволяют легче увеличить собственное присутствие в медиа и сделать его максимально позитивным. Все эти сервисы работают, как правило, с реальным исходником, предоставляя в итоге отполированный результат.

- Lovo.ai или Murf могут клонировать голос и улучшать его. Или создать новый с определенными интонациями;

- BrandYourself поможет проанализировать ваш цифровой след и «зачистить» некоторые хвосты;

- Jasper.ai снимет с вас бремя подбора идей для контента;

- Midjourney или Кандинский могут найти новое визуальное решение в любом контексте;

- Самая медийная нейросеть мира ChatGPT прекрасно заменит «линейного» райтера и аналитика;

- Captions позволит вам начитывать любой текст при съемке, но на видео надо смотреть прямо в камеру. Сервис поможет написать титры, исправит оговорки и даже синхронизирует ваше движение губ в нужном направлении.

Подобных сервисов уже десятки, процесс создания цифровых аватаров привел к тому, что сегодня у любого желающего есть возможность без грандиозных затрат управлять своим цифровым образом. Это понимают не только IT-компании и крупные бренды, но и представители мира политики и медиа. Последним только предстоит нащупать оптимальное взаимодействие с новыми технологиями, пока же видно, что нейросети в этой гонке обгоняют любое регулирование. И здесь кроется самая главная опасность — опасность подмены и манипуляций. Google только недавно задумался о дополнительной маркировке созданного при участии ИИ контента, после того, как противники Дональда Трампа сгенерили фейковое фото, где экс-президент США обнимает бывшего директора Национального института изучения аллергических и инфекционных заболеваний Энтони Фаучи, которого резко критиковал во время пандемии.

Этот скандал — продолжение давнего тренда. Команда того же Трампа на выборах 2016 года с помощью компании Cambridge Analytica довольно успешно соединила психологию с математикой. Огромная аналитическая работа по выявлению потребностей аудитории и созданию образа человека, который решает эти проблемы, помогла ему выиграть выборы. Но это были только первые шаги. Давайте представим, что нейросети новых поколений смогут выявлять потребности, компилировать сообщения и доставлять их десяткам миллионов избирателей в актуальном для каждого виде. А еще — адаптировать кандидата, его интонации и контент, для каждого. Думаю, что ждать осталось совсем недолго. И если сам кандидат не захочет в этом участвовать — оппоненты смогут принять такое решение за него.

Все это ставит перед нами ряд серьезных вопросов как прикладного, так и экзистенциального характера, ответы на которые нам придется искать в ближайшее время.

Эффективность продвижения

Например, большие бренды уже сейчас выбирают виртуальных инфлюэнсеров для продвижения. Один из наиболее известных кейсов — блогер Лил Микела, с которой сотрудничали крупнейшие бренды класса люкс. Примеры Balmain, Old Spice, Kelvin Klein, Valentino и прочих известных компаний как будто подтверждают, что с виртуальными персонажами сотрудничать безопаснее, дешевле и продуктивнее, чем с реальными людьми. Но если создавать аватара под конкретную бизнес-задачу со временем будет становиться все дешевле, то о качестве подобных «лидеров мнений» пока судить трудно. Заказчик идеологии персонажа — все равно компания. И при максимальной управляемости процесса скрыть собственные огрехи в ценностях, корпоративной культуре и управленческих решениях до конца не получится.

Другая проблема, актуальная и для политики и для бизнеса — безликость. Нейросети великолепно компилируют смыслы и образы. Однако привкус вторичности у такого контента все равно остается. Картинки, голоса, тексты — все это на существующем этапе развития нейросетей выглядит холодно и отстраненно. В них нет харизмы, эмоций, энергии и идей. Возможно, это удастся нивелировать на следующих этапах развития технологий — но только отчасти. Перед нами неизбежно встанет вопрос о создании новых смыслов. Мы живем в эпоху кризиса больших идей, но развитие ИИ еще больше подсветило эту проблему. Ни политика, ни мода в последние несколько десятков лет не производят ничего нового, мы ходим по кругу. Кажется, что пока решить эту проблему может только человеческая харизма. Однажды взорвавший рынок политтехнологий бывший президент США Барак Обама также был не оригинален, запустив свой известный слоган «Yes, we can» — он использовал речь американского общественного деятеля Мартина Лютера Кинга «I Have a Dream», перевел ее на современный лад и выступил с рефреном. Однако набор персональных характеристик позволил ему с успехом пройти предвыборную кампанию. Нюансы харизмы и индивидуальности стали предметом спора и в актерской гильдии США во время недавней забастовки. Селебрити отстаивают свое право получать отчисления за человеческую уникальность, даже если продакшн нанимает не живого актера, а создает его цифровую копию. Как бы то ни было, борьба за «исходник» — важный элемент противостояния в мире личных брендов.

Этика искусственного мира

Но, пожалуй, самый главный аспект использования новых технологий — этический. Уже сейчас технологии позволяют поместить цифрового персонажа в любой визуальный контекст и распространить заявления, сделанные от имени фейка под видом истинного сообщения. Вспомним тот же случай с Папой Римским Франциском в конце марта этого года, когда по всему интернету моментально распространилась фотография Его Святейшества в модном белом пуховике. В то, что Папа Римский облачился в совершенно не свойственную ему одежду, поверил, наверное, весь интернет. На самом деле картинка была сгенерирована нейросетью Midjourney.

У журналистов не так много инструментов, чтобы проверить, истинно ли, например, сообщение от имени пресс-службы нефтяной компании о разливе нефти и ущербе для экологии. А между тем такие фейковые новости могут обрушить котировки акций на радость инсайдерам.

Даже маркировку контента вряд ли сможет спасти ситуацию. Соцсети уже несколько лет маркируют, например, правительственный контент в разных странах. Или выявляют посты, нарушающие законодательство. Но это никак не работает с небольшими, но существенно важными «допущениями» — улучшенной внешностью или измененным контекстом. Более того, чтобы принцип маркировки заработал всерьез, крупным платформам придется самим вначале разработать искусственных полицейских — тот же ИИ, который будет мониторить нарушителей. Кстати, подобная профессия была уже внесена в списки профессий будущего.

Есть и более серьезные вопросы. И первый из них — это уместность применения нейросетей в отдельных видах коммуникации в принципе. До какой степени можно применять способности ИИ, чтобы продавать товары, услуги или даже собственную личность? И как определить, когда улучшение контента превращается в откровенный обман аудитории?

И тут мы приходим к любопытному выводу. Революция в области контента и технологий, которую мы сейчас наблюдаем, неизбежно обернется новым этапом борьбы за умы и сердца больших аудиторий. И надо понимать, что даже самые выверенные тексты или видео будут с большим трудом «продавать» эмоцию и аутентичность — ключ к принятию публикой тех самых решений. А регуляторы рано или поздно заставят политтехнологов и пиарщиков отвечать за откровенные подлоги. Так что при всем обилии инструментов работать с публичным образом станет только сложнее. В первую очередь решать придется ту самую проблему дефицита идей, смыслов и персональной харизмы. Обо всем остальном позаботится искусственный интеллект.

Мнение редакции может не совпадать с точкой зрения автора